2023年年底发布的第五代至强,虽然和第四代至强一样都是基Intel7制程打造的,并采用了Dual-poly-pitch SuperFin晶体管技术,但英特尔依然在关键的技术指标上做了改进,比如系统的漏电流控制和动态电容等。在这些改进下,整体上第五代至强在同等功耗下的频率可以提升3%,其中有2.5%是由漏电流控制贡献的,动态电容下降贡献了0.5%。

除此之外,第五代至强的多芯片封装方式有所改变,第四代至强就是把芯片分为四个部分,这四个部分是相对对称的。而第五代至强的切分方式则做了调整,把切四份的做法变成了切两份。过去每两片之间相互进行通信时,需要有一些芯片互连之间的接口,不仅占用了额外的芯片面积,也额外增加了功耗。如今随着芯片质量控制得到进一步改进,英特尔可以在相对较大的面积下依旧获得很好的良率,所以通过将四芯片改为两芯片的方式,芯片的面积得到了更好的控制。

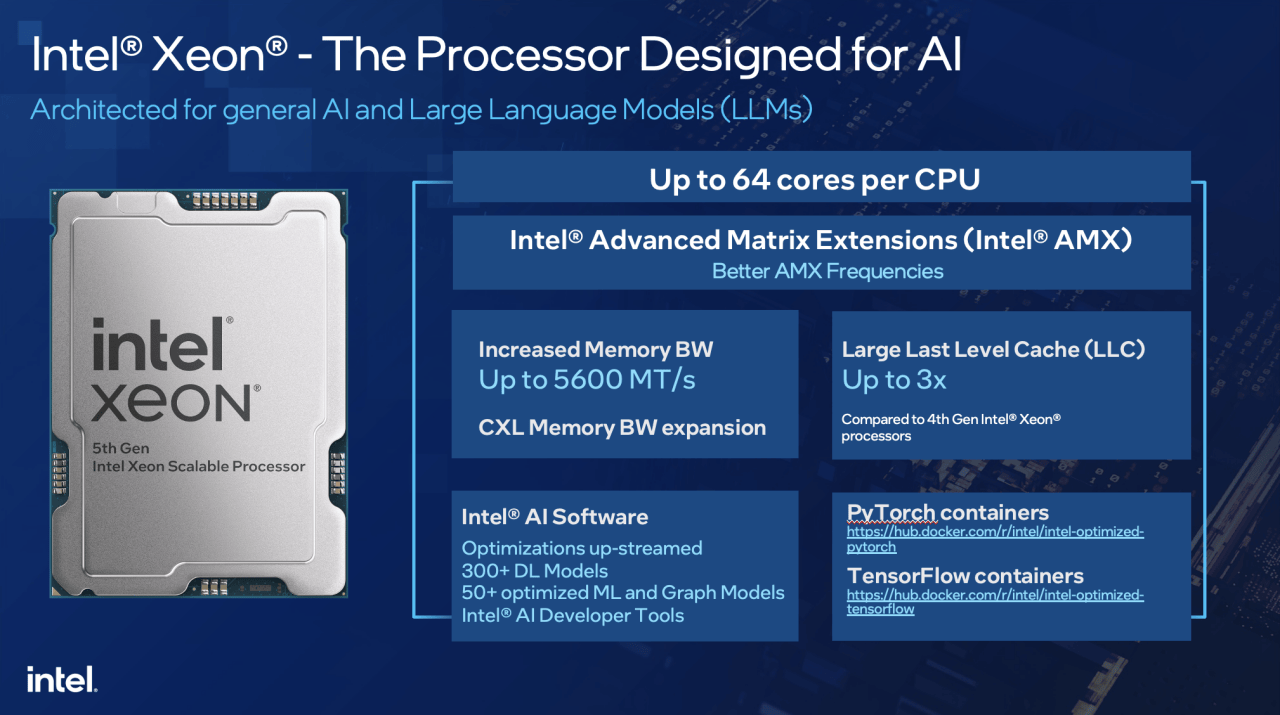

此外第五代至强的处理核心升级到了RaptotCove核心,核心数从最多的60核升级到64核。在I/O速度上,DDR速度从4800MT/s提升到了5600MT/s,UPI速度从16GT/s提升到20GT/s。而最大的升级之一当属LLC大小,单个模块的LLC容量从1.875MB增加到了5MB。这样如果处理规模较小的数据集时,甚至可以将主要数据放在LLC缓存中,从而大量减少内存访问,进而大幅提高性能。这些架构上的改进,也使其在生成式AI和LLM等AI应用上的性能得到了提升。

通用服务器上跑AI

除了传统的CPU计算核心外,英特尔也增加了AMX加速器,专门针对矩阵运算。根据测试,AI推理的性能与上一代相比提升了至多42%。针对非大模型类的AI应用,英特尔始终致力于在CPU上部署AI,并结合其OpenVINO生态进行优化,比如推荐、语音识别、图像识别等。

而面对推荐系统,尤其是面对GPU也无法单独处理的大模型时,CPU反而更快。因为GPU不够用的时候,玩玩需要跨GPU计算,或者需要和CPU频繁交互,如此一来CPU效率更高。

对于通用的AI工作负载,英特尔采用AMX和AVX-512两个指令集,基于OpenVINO进行优化。在推理的过程中,指令集上可以进行切分,通过加速器定向加速某一部分,甚至可以替代传统的基于GPU的AI模型。

除此之外,还有成本上的考量,在模型调优、推理、应用上,使用通用服务器有非常大的性价比提升。尤其是当企业并不需要24小时都要跑大模型,大模型只是对业务的辅助时,比如聊天机器人、或是内容生成、提纲分析等,这些只是帮助企业业务的生产力提高,尤其是在私有云上,就没有必要再重新部署一个新的GPU的平台。因为一个新的平台意味着需要考虑开发、运维等因素,成本有可能增加,而这对于企业来说也可能会成为负担。

以合作伙伴举例,比如百度云也有基于第五代至强的服务器,提供了可以在CPU上运行的大型计算模型的服务;在京东基于第五代至强的应用中可以看到,和前一代的处理器相比,在Llama2 13B的模型上,看到有50%的性能提升。所以第五代至强在AI上应用的性能提升是比较明显的。

再者就是编解码上的应用,目前主流客户为了达到更好的图像质量,反而会采用CPU做编解码。GPU在拥有硬件加速的情况下,其特点是快,但视频编解码质量往往略差于CPU。通过第五代至强处理器AMX-INT8的加持,已经把吞吐从原来的1.5FPS增强到了33FPS,基本可以满足实时编码的需求。

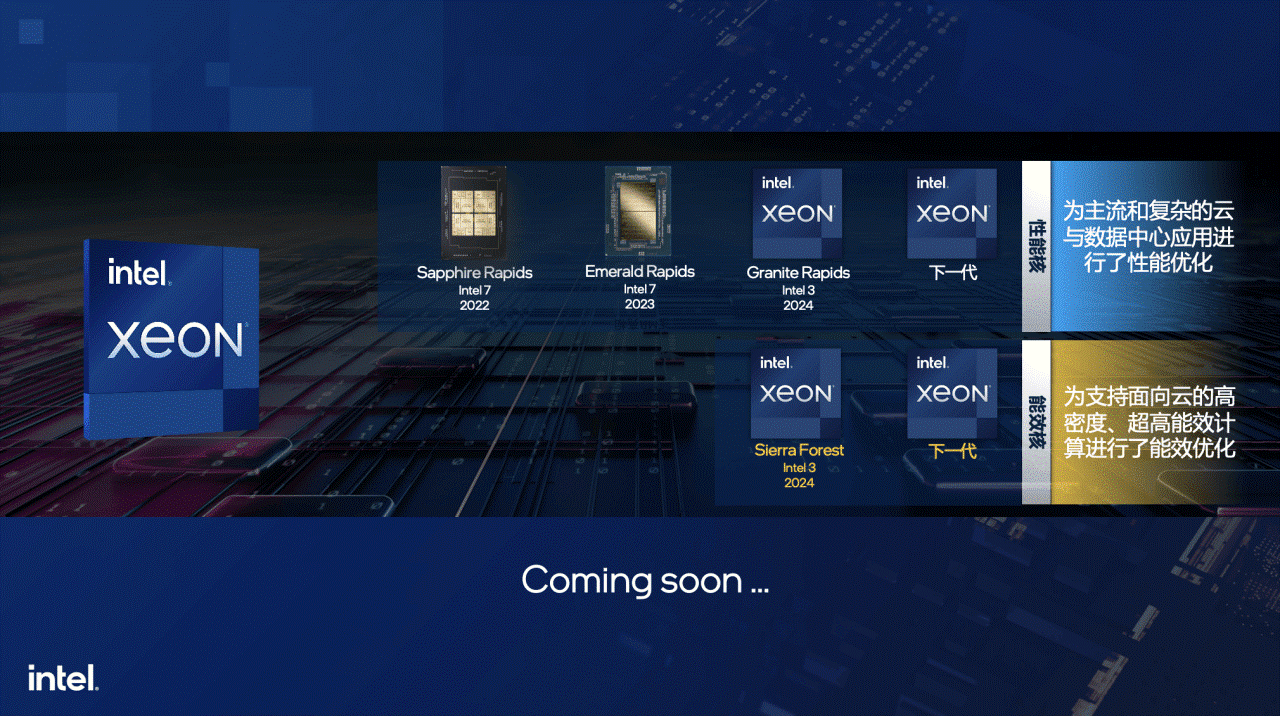

下一代至强路线图

从路线图上来看,2024年英特尔还会发布新一代英特尔至强可扩展处理器,而且有一个非常丰富的产品组合,同时满足对性能和能耗的要求。基于现在的第五代至强,英特尔也会发布下一代的性能核,就是高主频、高性能的CPU核架构,为主流和复杂的数据中心的应用进行性能优化,尤其是目前有很多程序是跑在虚拟机上,之前写的非常大的程序要跑在性能核上的,才能看到一个非常好的性能提升。

同时对新兴的,尤其是基于云原生的设计,英特尔还提供基于能效核打造的至强处理器,每瓦性能可以做到相对极致,而且因为它的核心设计比较精简,可以放更多高密度的核数到每一款的CPU和服务器,从而支持面向云的高密度超高能效的运算进行能效的优化。在近期对于产品淘汰换新的要求中,有一个重要考量因素就是能效比,这同样也是符合国家对设备淘汰换新的要求。

Copyright © 2022 厦门雄霸电子商务有限公司漳州分公司 All Rights Reserved. 闽ICP备20016028号

扫一扫咨询微信客服

扫一扫咨询微信客服